La privacidad y seguridad de Claude (CoWork)

CALENDARIO de próximos CURSOS 😄

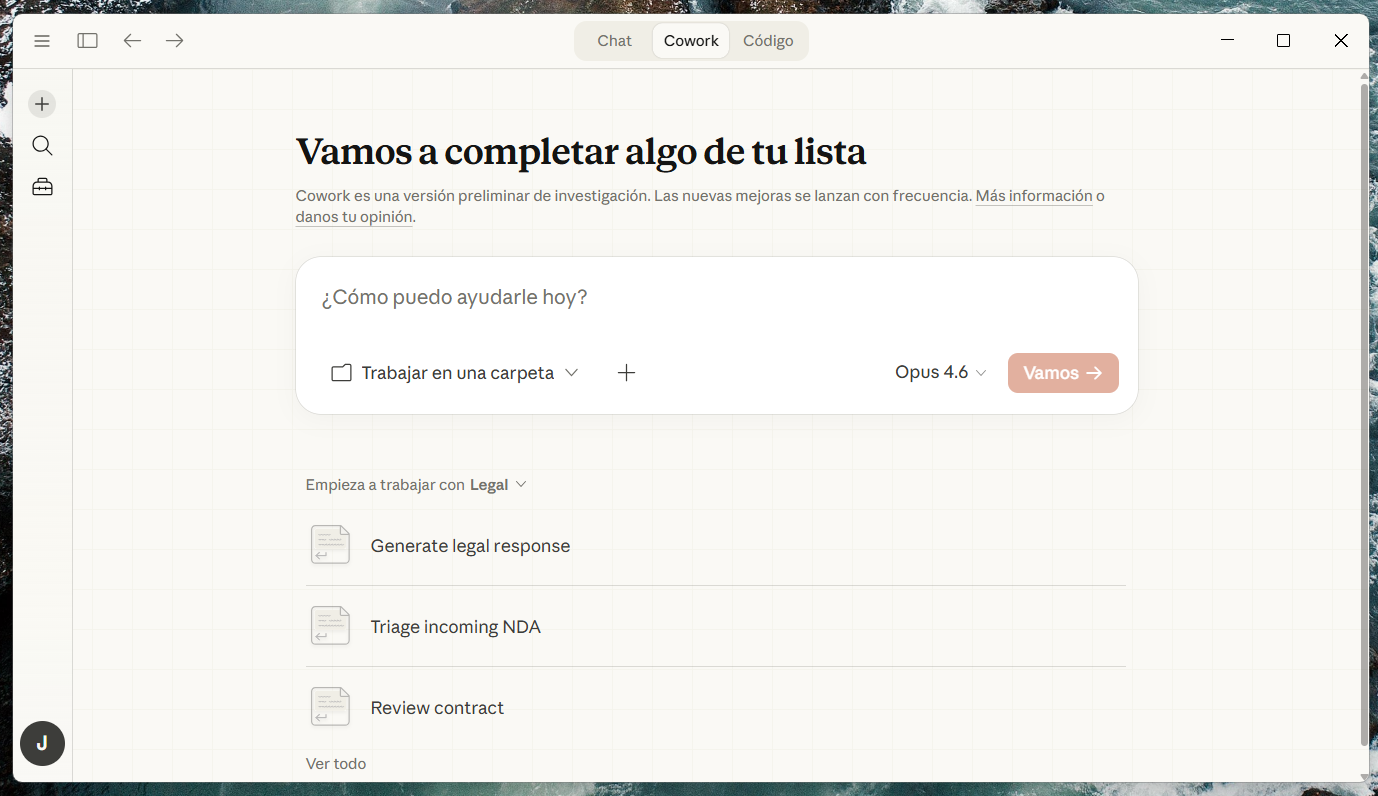

Anthropic lanzó en enero de 2026 Claude CoWork, una nueva herramienta en research preview o versión preliminar que promete llevar las capacidades agénticas de Claude Code al escritorio de profesionales no técnicos.

Ya hablamos la semana pasada sobre sus plugins en tareas de conocimiento, incluidos los legales.

La idea de CoWork es atractiva: describes el resultado que necesitas, te vas a por un café, y al volver tienes un informe redactado, tus descargas organizadas o un spreadsheet con fórmulas funcionales. Es decir, múltiples tareas en paralelo, con subagentes y control sobre el equipo y su contenido directamente.

Para los que trabajamos en el sector legal, CoWork despierta un interés inmediato: ¿podría convertirse en ese asistente que organiza expedientes, sintetiza documentación de due diligence o genera borradores de informes? Posiblemente.

Pero antes de cederle acceso a nuestras carpetas, conviene abrir el capó y examinar qué ocurre realmente con nuestros datos.

Tres Claudes, 3 modelos de privacidad

No todos los Claude funcionan igual en materia de protección de datos. Entender las diferencias entre el chatbot web/móvil, Claude Code y CoWork es esencial para cualquier profesional que maneje información sensible.

Claude como chatbot (web, escritorio y móvil) opera bajo los Consumer Terms de Anthropic. Desde la actualización de septiembre de 2025, los usuarios de los planes Free, Pro y Max pueden optar por permitir que sus conversaciones se utilicen para entrenar futuros modelos. Si se acepta, el periodo de retención asciende a cinco años; si se rechaza, se mantiene en 30 días. Las conversaciones en modo Incógnito quedan excluidas del entrenamiento en todo caso. Es importante destacar que la opción de entrenamiento viene activada por defecto, lo que exige una acción del usuario para desactivarla en la configuración de privacidad.

Claude Code, orientado a desarrolladores, sigue las mismas reglas para cuentas de consumidor, pero añade matices relevantes: los datos se transmiten cifrados en tránsito mediante TLS, aunque no se cifran en reposo. Para usuarios comerciales (Team, Enterprise, API), Anthropic no entrena modelos con los datos salvo que el cliente opte expresamente a programas como el Developer Partner Program. Además, con claves API configuradas adecuadamente, es posible activar una política de zero data retention.

Y aquí llega CoWork, con un modelo que rompe esquemas. Según la propia documentación de Anthropic, CoWork almacena el historial de conversaciones localmente en el equipo del usuario, de modo que no está sujeto a los plazos de retención de datos estándar de la compañía. Además, y a diferencia de Claude Code, que opera en el terminal del desarrollador con los mismos permisos del usuario del sistema operativo, CoWork ejecuta todas las tareas dentro de una máquina virtual (VM) aislada, a ello se añade otra capa de aislamiento, restringiendo llamadas al sistema y privilegios. Por tanto, el doble aislamiento es más restrictivo por diseño, al estar dirigido a usuarios no técnicos.

Ahora bien, la actividad de CoWork no queda registrada en Audit Logs, Compliance API ni Data Exports. De hecho, Anthropic lo dice con todas las letras: "Do not use Cowork for regulated workloads" 😬 En otras palabras, su uso queda expresamente desaconsejado para cargas de trabajo sujetas a cumplimiento normativo.

Las ventajas (y su letra pequeña)

El almacenamiento local de CoWork representa, curiosamente, tanto su mayor fortaleza como su mayor debilidad en materia de privacidad.

Del lado positivo, que las conversaciones no residan en los servidores de Anthropic significa que, en principio, no alimentan el entrenamiento de modelos y no están expuestas a las mismas políticas de retención de datos. Para un abogado que revisa documentación confidencial, esto podría parecer una garantía superior a la del chatbot convencional.

Sin embargo, hay otra cara de la moneda más negativa. CoWork ejecuta tareas en una máquina virtual que corre en el equipo del usuario, con acceso directo a las carpetas que este autorice. Y aquí es donde la research preview muestra sus costuras: apenas semanas después de su lanzamiento en enero de 2026, la firma de seguridad PromptArmor demostró públicamente cómo un atacante podía, mediante inyección de prompts en un documento aparentemente inofensivo, conseguir que CoWork exfiltrara archivos del usuario hacia una cuenta de Anthropic controlada por el atacante.

La vulnerabilidad, que ya había sido detectada previamente en Claude Code y reportada a Anthropic a través de HackerOne en octubre de 2025, fue inicialmente descartada por la compañía como fuera de alcance del programa de reporte de bugs.

Dicho de forma más gráfica: imagina que conectas CoWork a tu carpeta de expedientes de un cliente y, entre la documentación, se cuela un PDF manipulado por un tercero malintencionado. Sin que tú lo percibas, CoWork podría subir archivos sensibles a una cuenta ajena. No tenemos caso real todavía, pero sí sabemos que es factible hacerlo.

Anthropic ha reconocido expresamente que CoWork, por su naturaleza agéntica y su acceso a internet, presenta riesgos únicos, y ha trasladado al usuario la responsabilidad de "evitar dar acceso a archivos locales con información sensible". Pero a la vez, promociona la herramienta para organizar tu escritorio y procesar tus documentos 😅

El caso Heppner: cuando Claude deja de ser confidencial

Para entender el alcance real de estas cuestiones de privacidad en el ámbito jurídico, conviene detenerse en la reciente resolución del juez Jed S. Rakoff del Tribunal de Distrito Sur de Nueva York, dictada el 10 de febrero de 2026 en el caso United States v. Heppner (25-cr-00503-JSR). Bradley Heppner, un ejecutivo financiero acusado de fraude de valores, utilizó la versión de consumidor (gratuita) de Claude para investigar cuestiones legales de su caso, alimentando el modelo con información que había recibido de sus abogados de Quinn Emanuel.

Posteriormente, envió los 31 documentos generados por la IA a su equipo de defensa.

El juez Rakoff resolvió que esos documentos no estaban protegidos por el privilegio abogado-cliente ni por la doctrina del “work product”. Su razonamiento se centra en principios clásicos del common law: el privilegio exige una comunicación confidencial entre cliente y abogado, y un sistema de IA no es ni puede ser abogado. No tiene licencia, no debe lealtad fiduciaria y no está sujeto a regulación profesional. Por si fuera poco, la Política de Privacidad de Anthropic vigente establecía expresamente que los prompts podían ser utilizados para entrenar el modelo y que los datos podían ser divulgados a autoridades gubernamentales y terceros.

En palabras del juez: Heppner divulgó la información a un tercero, la IA, que contaba con una disposición expresa de que lo enviado no era confidencial.

El aspecto más llamativo de la resolución es su posible efecto dominó: el Gobierno argumentó, y Rakoff admitió, que compartir comunicaciones privilegiadas con una plataforma de IA de consumo puede constituir una renuncia al privilegio sobre las propias comunicaciones originales abogado-cliente. Es decir, no solo los documentos generados por la IA dejan de ser confidenciales, sino que potencialmente se arrastra la pérdida de privilegio a la información original que se introdujo como prompt.

Con todo, el propio Rakoff dejó una puerta abierta interesante al señalar que, si el abogado hubiera dirigido a su cliente a utilizar Claude y se hubieran mantenido garantías de confidencialidad, podría haberse invocado la doctrina Kovel, que extiende el privilegio a profesionales no abogados contratados por el letrado para asistir en el asesoramiento jurídico. Rakoff llegó a afirmar que, bajo esas circunstancias, Claude podría haber funcionado de manera análoga a un profesional cualificado que actúa como agente del abogado.

Una afirmación que, sin duda, abre un debate fascinante sobre el estatus jurídico de las herramientas de IA en el contexto del asesoramiento legal.

¿Y cómo encaja CoWork en todo esto?

Si aplicamos la lógica de Rakoff al ecosistema de productos de Anthropic, emerge una paradoja interesante. CoWork, al almacenar las conversaciones localmente y no estar sujeto a los plazos de retención de Anthropic, podría presentar un perfil de confidencialidad aparentemente más favorable que el chatbot convencional que fue objeto de la resolución. En teoría, los datos no viajan a los servidores de Anthropic para entrenamiento (al menos no bajo el modelo declarado), lo que debilitaría el argumento de divulgación a terceros.

Pero esta aparente ventaja se desmorona por varias razones.

Primera: CoWork sigue procesando los datos a través de los modelos de Anthropic en la nube para generar sus respuestas; el almacenamiento local no implica que la inferencia sea local.

Segunda: la vulnerabilidad de exfiltración documentada demuestra que la seguridad del entorno es, como mínimo, inmadura.

Tercera: la propia Anthropic desaconseja su uso para “regulated workloads” y advierte de que la actividad no se registra en logs de auditoría, lo que resulta incompatible con las obligaciones de trazabilidad y accountability que exigen tanto el RGPD como el Reglamento de IA, entre otras.

Cuarta: su condición de research preview implica que las garantías y condiciones pueden cambiar en cualquier momento sin previo aviso.

Para los planes Enterprise y Team, las cosas no mejoran sustancialmente. Aunque los Commercial Terms de Anthropic prohíben expresamente el entrenamiento de modelos con datos comerciales, CoWork queda fuera de los mecanismos de auditoría y cumplimiento, lo que genera un ángulo muerto en la gobernanza corporativa del uso de IA ya que no habría opción de supervisión.

Conclusión

CoWork representa un paso ambicioso hacia el futuro de la automatización del trabajo del conocimiento, incluido el jurídico. Pero su estado actual de research preview todavía lo sitúa en una tierra de nadie regulatoria y de seguridad que debería implicar ir todavía a tientas y plantearse a qué carpetas conectarlo.

La resolución del juez Rakoff en Heppner nos recuerda que las herramientas de IA de consumo no son un espacio seguro para la información privilegiada, y que los términos y condiciones de estos productos importan, y mucho, a efectos procesales. La distinción entre herramientas consumidor y empresa no es una cuestión de marketing: es una línea que puede determinar si tu estrategia de defensa acaba siendo prueba de cargo.

¿Significa esto que hay que huir de CoWork? No necesariamente, pero sí que hay que tratarlo como lo que es: una herramienta experimental con capacidades prometedoras pero con garantías de privacidad y seguridad insuficientes para el tratamiento de datos sensibles o información privilegiada. Para tareas no sensibles, como organizar archivos genéricos o generar plantillas estándar, está claro que es un aliado eficaz. Para cualquier cosa que roce la confidencialidad profesional, quizá mejor esperar a que madure o, como mínimo, optar por entornos Enterprise con garantías contractuales sólidas.

Además, hace tan poco desde su lanzamiento, que lo normal es que funciones que sí están presentes en su hermano mayor Claude Code (por ejemplo, el control granular de permisos, la exportación de datos o los logs de auditoría), acaben llegando a a CoWork también.

Mientras tanto, deberemos seguir con cautela en cuanto a cajas negras que incluyen un aviso de exención de responsabilidad. 😅

Jorge Morell Ramos

Dicho esto, ahí va la actualidad del 2 al 8 de febrero de 2026 en IA y Derecho (publicaré todas las semanas pendientes, las tengo recopiladas).

56 noticias sobre regulación, tribunales, propiedad intelectual e industrial, protección de datos, Legaltech y otras.